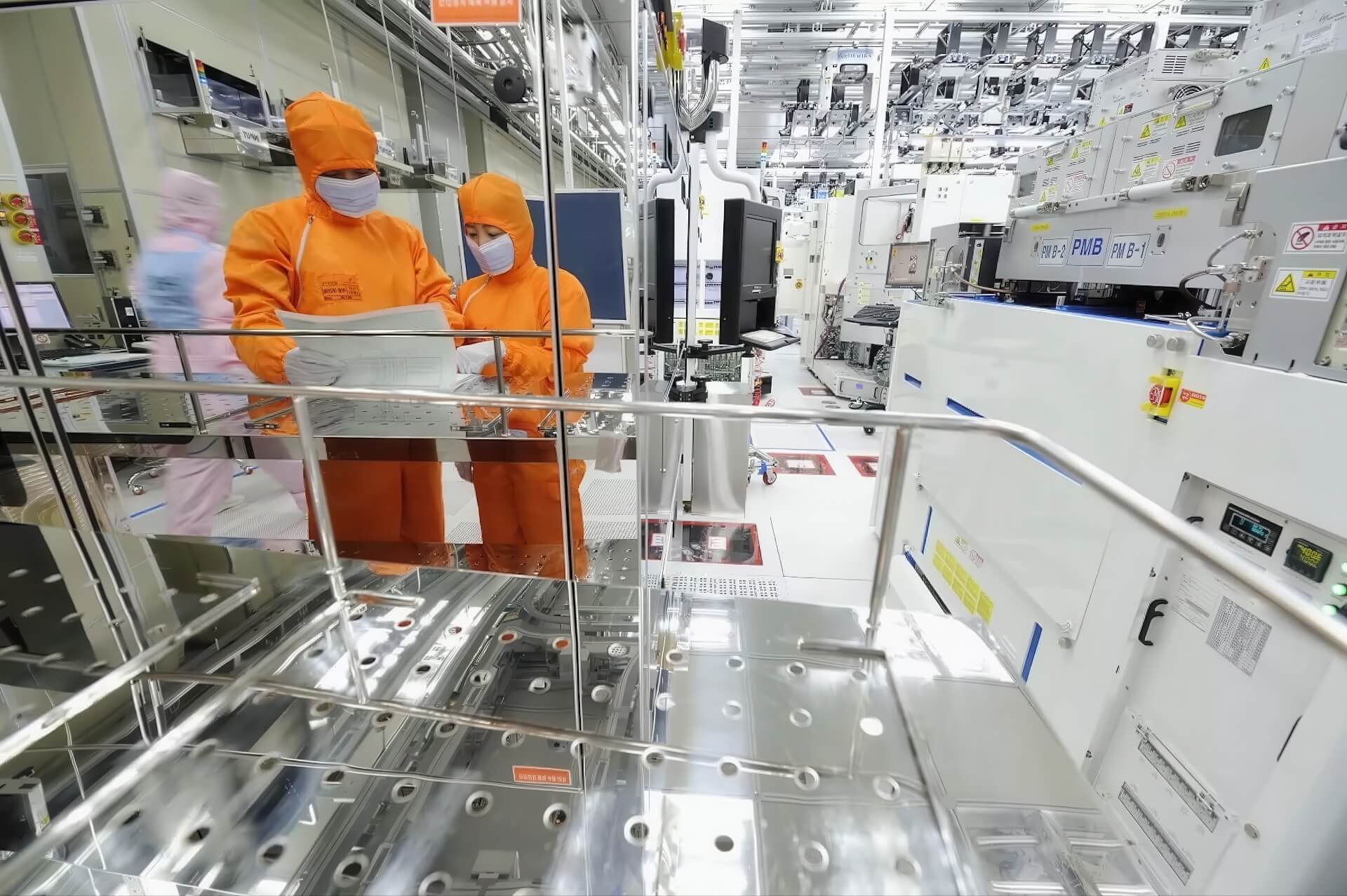

SK Hynix cho biết họ đã bán hết nguồn cung sản phẩm bán dẫn chủ chốt của năm tới, do nhu cầu mạnh mẽ đối với các chip nhớ hiệu suất cao phục vụ hệ thống trí tuệ nhân tạo (AI). Kết quả kinh doanh quý 3 của công ty Hàn Quốc này cho thấy sự chuyển đổi nhanh chóng của ngành dưới sức nặng của đầu tư AI, với lợi nhuận đạt mức kỷ lục và lịch trình sản xuất đã được đặt kín đến tận năm 2026. Điều này xác nhận rằng, cơn sốt chip nhớ cao cấp, đặc biệt là HBM, đang tạo ra một sự mất cân bằng lớn giữa cung và cầu trên thị trường toàn cầu.

Nhu cầu HBM vượt quá cung: Lợi nhuận kỷ lục của SK Hynix

Nhà sản xuất chip Hàn Quốc này đã báo cáo lợi nhuận hoạt động đạt 11,4 nghìn tỷ won (8 tỷ USD) trong ba tháng kết thúc vào ngày 30 tháng 9, tăng 62% so với cùng kỳ năm ngoái. Doanh thu tăng 39% so với cùng kỳ năm trước, đạt 22,4 nghìn tỷ won, được thúc đẩy bởi các đơn đặt hàng mạnh mẽ cho chip nhớ băng thông cao (HBM) của hãng.

Các giám đốc điều hành cho biết nhu cầu về công nghệ bộ nhớ mới nhất của SK Hynix tiếp tục vượt quá nguồn cung. Kim Kyu-hyun, Trưởng bộ phận tiếp thị DRAM, mô tả thị trường cho cả bộ nhớ DRAM và NAND là “cực kỳ eo hẹp,” lưu ý rằng khách hàng đã đảm bảo các vị trí sản xuất cho chip nhớ thông thường kéo dài đến năm 2026.

“Năng lực sản xuất DRAM, NAND, cũng như HBM của chúng tôi cho năm tới đã được bán hết”, ông nói với The Financial Times. Sự mất cân bằng giữa cung và cầu này rõ rệt nhất trong phân khúc HBM. Công ty nghiên cứu TrendForce lưu ý rằng SK Hynix kiểm soát hơn một nửa thị trường HBM toàn cầu và sản xuất các chip được sử dụng trong nhiều bộ tăng tốc AI của Nvidia. Đối thủ Samsung Electronics nắm giữ hơn một phần tư thị trường, trong khi Micron Technology ở Hoa Kỳ chiếm phần lớn còn lại.

Hợp đồng lớn với OpenAI và kế hoạch tăng vốn cho HBM4

Nhu cầu mạnh mẽ do AI thúc đẩy cũng đã định hình lại các quan hệ đối tác chiến lược. Đầu tháng này, SK Hynix và Samsung mỗi công ty đã ký các thỏa thuận sơ bộ với OpenAI để cung cấp chất bán dẫn cho dự án trung tâm dữ liệu siêu máy tính “Stargate” trị giá 500 tỷ USD được đề xuất của công ty này.

SK Hynix cho biết nhu cầu dự kiến chỉ từ sáng kiến đó thôi đã có thể làm tăng gấp đôi năng lực HBM hiện có của ngành. Công ty có kế hoạch tăng đáng kể chi tiêu vốn để đáp ứng những dự báo đó và xác nhận rằng họ gần đây đã hoàn tất đàm phán về các hợp đồng cung cấp HBM với tất cả các khách hàng lớn cho năm 2025.

Công ty dự kiến sẽ bắt đầu sản xuất hàng loạt chip HBM4 thế hệ tiếp theo vào quý 4 năm 2025. Kim Ki-tae, Trưởng bộ phận bán hàng và tiếp thị HBM, cho biết việc ra mắt chip này sẽ đại diện cho một bước nhảy vọt đáng kể về hiệu quả xử lý dữ liệu. Tuy nhiên, ông cũng cảnh báo rằng việc đáp ứng nhu cầu thị trường sẽ vẫn là một thách thức trong thời gian tới. “Nhu cầu HBM tiếp tục tăng nhanh chóng, vì vậy sẽ khó để nguồn cung bắt kịp trong thời gian ngắn,” ông nói.

Các chuyên gia trong ngành cho rằng triển vọng của công ty sẽ vẫn gắn chặt với quỹ đạo rộng lớn hơn của cơ sở hạ tầng AI. Các nhà phân tích của Citi lưu ý rằng suy luận AI (AI inference) đã làm tăng mạnh nhu cầu về bộ nhớ máy chủ hiệu suất cao, không chỉ ở Hoa Kỳ mà còn ở Trung Quốc, nơi các công ty đám mây siêu lớn (hyperscale cloud companies) đang tăng tốc các khoản đầu tư tương tự. Counterpoint Research dự đoán thị trường HBM toàn cầu sẽ đạt khoảng 43 tỷ USD vào năm 2027, với cả SK Hynix và Samsung đều được hưởng lợi từ nhu cầu ngày càng tăng này. Điều này củng cố vị thế dẫn đầu của SK Hynix trong kỷ nguyên AI.

1 bình luận về “SK Hynix bán sạch chip DRAM, NAND, HBM đến năm 2026 vì AI”