Cuộc cạnh tranh lớn nhất của Nvidia trong ngành công nghiệp Trí tuệ Nhân tạo (AI), vốn đã nổi lên như một đối thủ đáng gờm, hiện không phải là AMD hay Intel, mà chính là Google. Gã khổng lồ tìm kiếm đang nhanh chóng bắt kịp trong cuộc đua phần cứng AI. Điều thú vị là, CEO Nvidia Jensen Huang dường như đã nhận thức rõ về mối đe dọa này. Thoạt nhìn, điều này có vẻ đáng ngạc nhiên, nhưng Google là một trong những đối thủ cạnh tranh sớm nhất trong cuộc đua phần cứng AI, đã giới thiệu chip TPU (Tensor Processing Unit) tùy chỉnh đầu tiên của mình vào năm 2016, sớm hơn nhiều so với AMD, Nvidia và Intel. Tuần trước, gã khổng lồ công nghệ này đã giới thiệu TPU Ironwood thế hệ thứ 7 mới nhất, một sự kiện gây chấn động ngành công nghiệp và củng cố ý tưởng về một cuộc đua AI cạnh tranh khốc liệt nhất giữa “Nvidia vs Google”.

TPU Ironwood: Khả năng suy luận vượt trội và bộ nhớ HBM khổng lồ

Google’s TPU Ironwood dự kiến sẽ sớm có mặt trên nhiều khối lượng công việc khác nhau. Công ty xác định chip này là một giải pháp tập trung vào suy luận (inference-focused), tuyên bố rằng nó sẽ mở ra một kỷ nguyên mới về hiệu suất suy luận trong tính toán mục đích chung. TPU v7 (Ironwood) được định vị để tận dụng sự dịch chuyển của thị trường từ đào tạo mô hình sang suy luận, đó là lý do tại sao các thông số kỹ thuật của nó được thiết kế để vượt trội trong “kỷ nguyên suy luận”. Dưới đây là một số đặc điểm chính:

- Cải thiện hiệu suất đỉnh gấp 10 lần so với TPU v5p.

- Hiệu suất trên mỗi chip tốt hơn 4 lần cho cả khối lượng công việc đào tạo và suy luận so với TPU v6e (Trillium).

- Là chip silicon tùy chỉnh mạnh mẽ và hiệu quả năng lượng nhất được Google chế tạo cho đến nay.

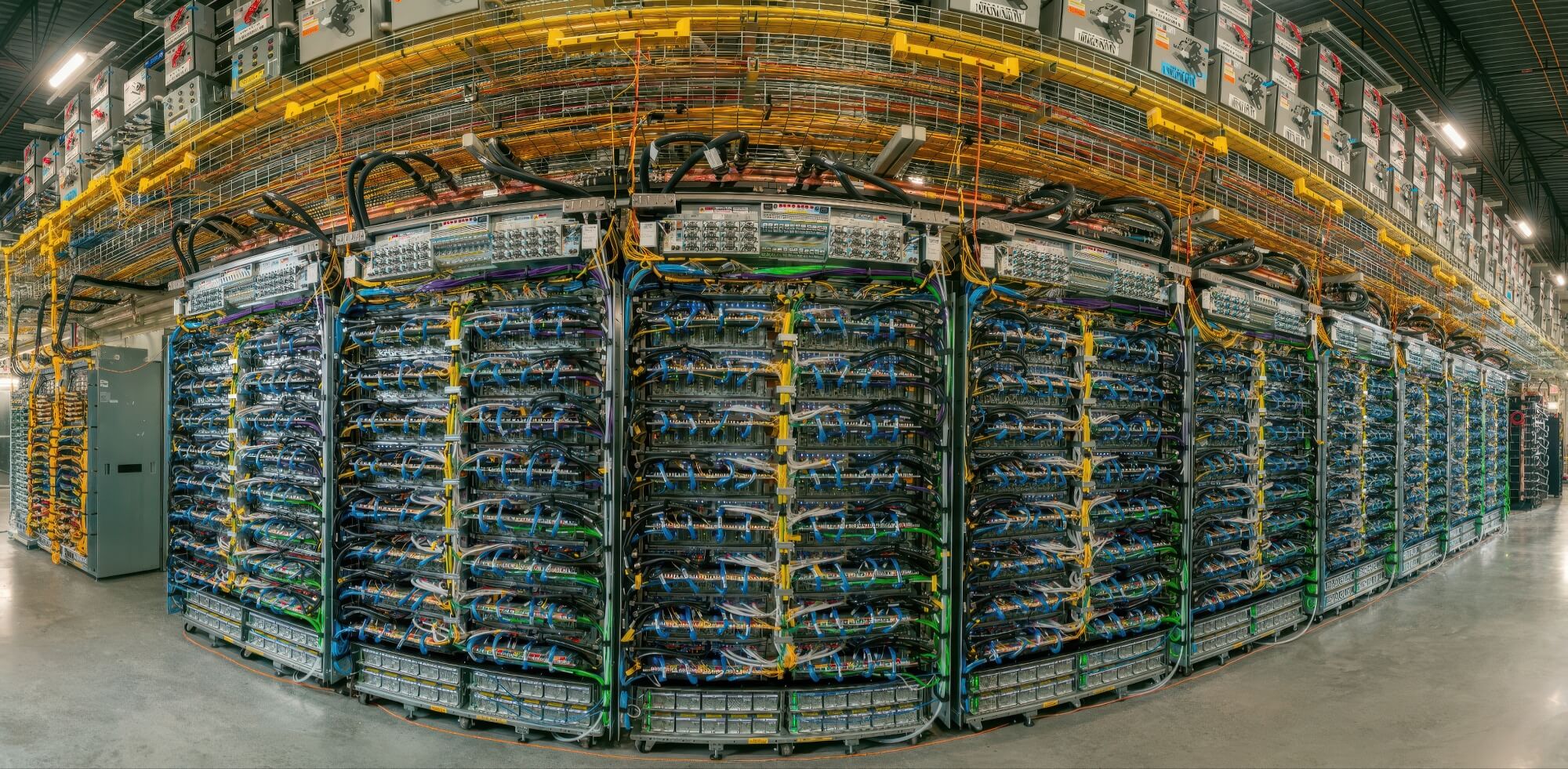

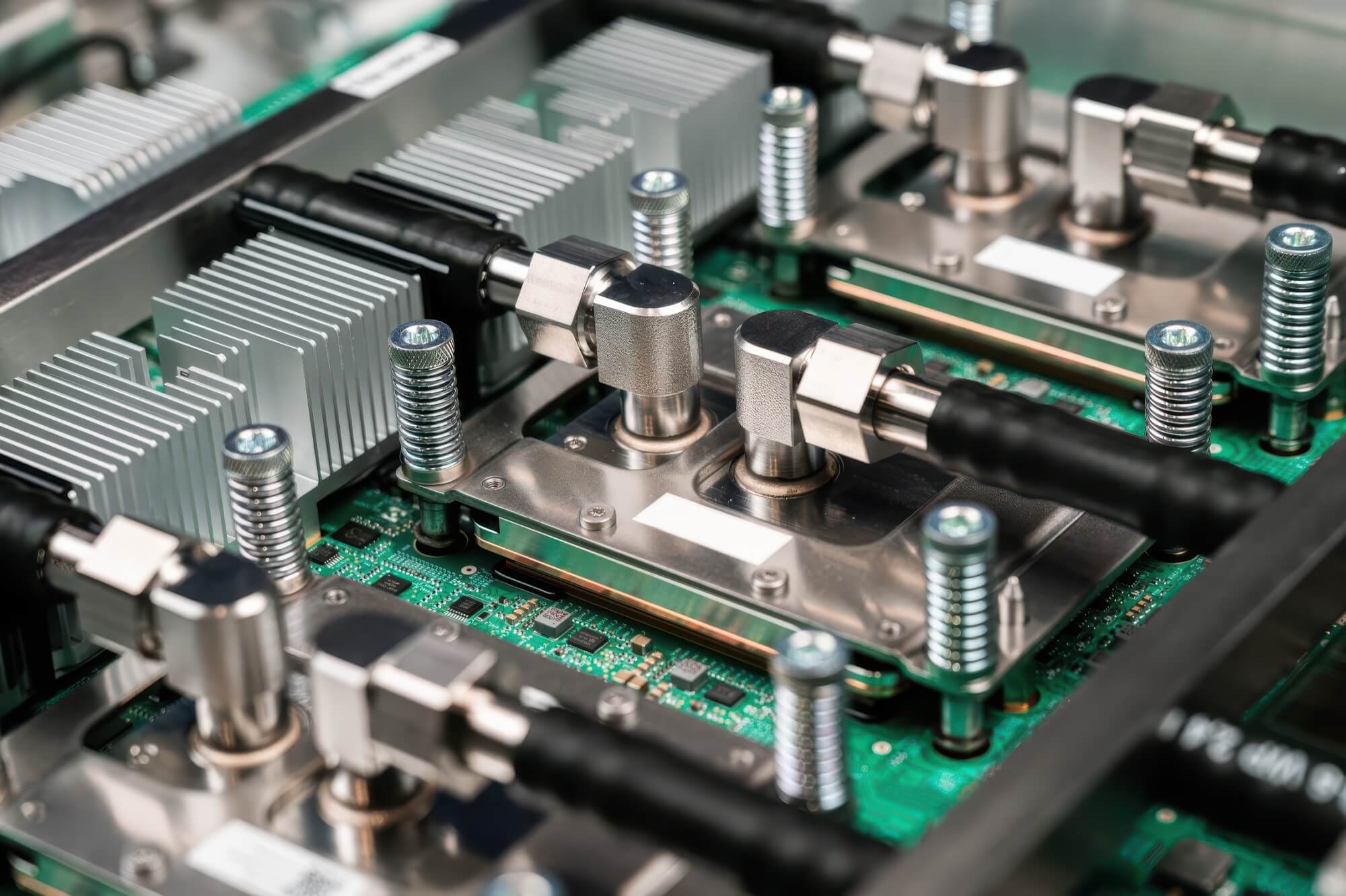

Đi sâu vào các thông số kỹ thuật của chip Ironwood, Google dự kiến sử dụng 192 GB bộ nhớ HBM tốc độ 7.4 TB/s và đạt tới 4.614 TFLOPs hiệu suất đỉnh FLOPs trên mỗi chip. Mức này tăng gần 16 lần so với TPUv4. Quan trọng hơn, với TPU Superpod Ironwood, Google tích hợp 9.216 chip trong một pod duy nhất, mang lại hiệu suất cộng dồn là 42.5 exaFLOPS trong các khối lượng công việc tính toán FP8 tổng hợp. Số lượng chip lớn này cho thấy Google có một giải pháp kết nối hiệu quả, thậm chí đã vượt qua NVLink của Nvidia về khả năng mở rộng.

| Thông số kỹ thuật | Hiệu suất |

|---|---|

| Hiệu suất đỉnh trên mỗi chip (FP8) | ~ 4,614 TFLOPS |

| Dung lượng HBM trên mỗi chip | 192 GB HBM3e |

| Băng thông bộ nhớ trên mỗi chip | ~ 7.2 TB/s |

| Kích thước pod tối đa (# chip) | 9,216 chips |

| Hiệu suất đỉnh trên mỗi pod | ~ 42.5 ExaFLOPS |

| Bộ nhớ hệ thống trên mỗi pod (HBM) | ~ 1.77 PB |

| Băng thông Inter-Chip Interconnect (ICI) | ~ 1.2 Tb/s mỗi liên kết |

| Cải thiện hiệu suất | ~ 16× so với TPU v4 |

Khả năng mở rộng và hiệu suất/chi phí: Điểm mạnh của Google

Về khả năng kết nối, Google sử dụng mạng InterChip Interconnect (ICI), một mạng mở rộng quy mô (scale-up network). Mạng này cho phép họ kết nối 43 khối (mỗi khối gồm 64 chip) của Superpods thông qua một mạng lưới 1.8 Petabytes. Liên lạc nội bộ được xử lý bằng cách sử dụng một loạt các NIC, và Google sử dụng bố cục 3D Torus cho các TPU của mình, cho phép kết nối mật độ cao trên số lượng lớn chip. So với NVLink của Nvidia, Google chiến thắng ở khả năng mở rộng và mật độ kết nối. Đó là lý do tại sao SuperPod được định vị là một sản phẩm mang tính đột phá.

Trong suy luận, vấn đề không chỉ là đạt được nhiều TFLOPS nhất; thay vào đó, các chỉ số khác trở nên quan trọng, chẳng hạn như độ trễ, thông lượng, hiệu quả và chi phí trên mỗi truy vấn. Đây là lý do tại sao khi nhìn vào những gì Google cung cấp với Ironwood, ý tưởng về “Google vượt trội Nvidia trong cuộc đua AI” trở nên rõ ràng hơn nhiều. Thứ nhất, Ironwood có bộ nhớ lớn trên gói (on-package memory), tương đương với GPU AI Blackwell B200 của Nvidia. Tuy nhiên, khi tính đến cụm SuperPod có 9.216 chip trong một môi trường duy nhất, dung lượng bộ nhớ khả dụng vượt trội đáng kể.

Bộ nhớ cao hơn cực kỳ quan trọng cho suy luận, vì nó làm giảm chi phí giao tiếp giữa các chip và cải thiện độ trễ cho các mô hình lớn. Ironwood’s architecture is explicitly designed for inference, which means that Google has specifically focused on ensuring low-latency, backed with high power efficiency, and we’ll talk about power ahead, which is the ‘second-most’ important factor behind Ironwood’s potential success.

Khả năng thống trị trong Kỷ nguyên Suy luận và rủi ro Khóa hệ sinh thái

Việc suy luận trên quy mô siêu lớn yêu cầu hàng nghìn chip để phục vụ các truy vấn, tất cả đều trong môi trường hoạt động 24/7. Các Nhà cung cấp Dịch vụ Đám mây (CSPs) có xu hướng tập trung hơn vào chi phí triển khai và vận hành hơn là hiệu suất tuyệt đối. Điều này khiến Ironwood trở nên hấp dẫn hơn, vì Google đã đạt được hiệu quả năng lượng cao hơn gấp 2 lần so với các thế hệ trước, khiến việc triển khai TPU của Google trên các khối lượng công việc suy luận trở thành một động thái hợp lý hơn.

Cuộc đua AI đang thay đổi từ “ai có nhiều flops hơn” sang “ai có thể phục vụ nhiều truy vấn hơn, với độ trễ thấp hơn, chi phí thấp hơn và tiêu thụ ít điện năng hơn”. Điều này đã mở ra một trục cạnh tranh mới mà Google đang tìm cách nắm bắt sớm. Quan trọng hơn, Ironwood được cho là sẽ được cung cấp độc quyền dưới Google Cloud. Điều này có thể tạo ra một sự khóa chặt hệ sinh thái (ecosystem lock-in) – một đòn chí mạng tiềm năng đối với sự thống trị AI lâu đời của Nvidia.

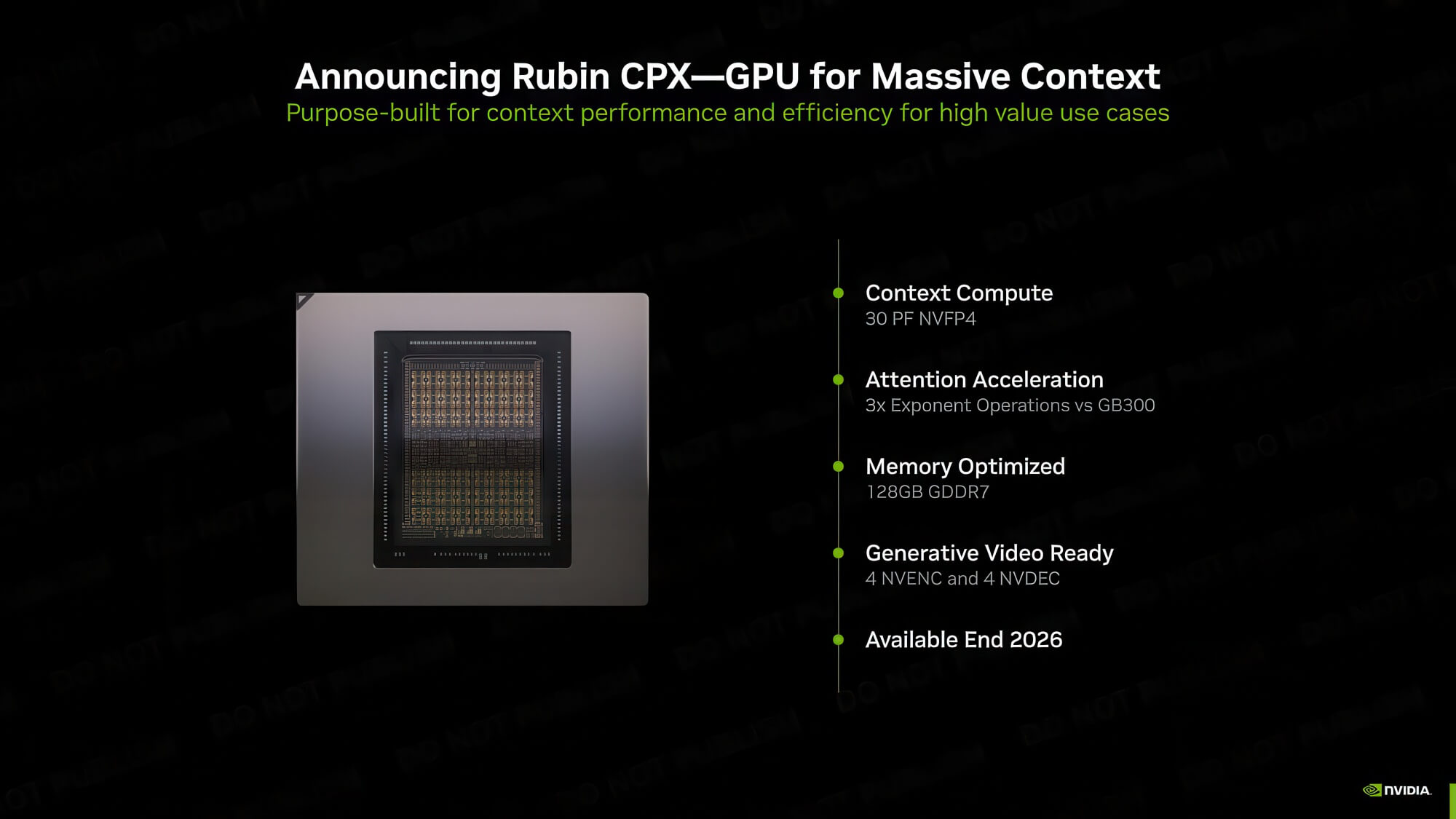

Nvidia không hề đứng yên với sự khởi đầu của suy luận, khi hãng lên kế hoạch cung cấp một “điểm ngọt” với các giải pháp quy mô rack Rubin CPX. Tuy nhiên, rõ ràng theo thời gian, Google đang định vị mình là “đối thủ thực sự” của Nvidia, với Intel và AMD đang tụt lại phía sau. Chính CEO Jensen Huang cũng đã thừa nhận: “TPU đang ở thế hệ TPU 7… Thử thách đối với những người đang xây dựng ASIC [chip tùy chỉnh] là rất khó khăn. Công việc mà họ làm là vô cùng khó khăn.” Điều này cho thấy Nvidia biết rất rõ về khả năng cạnh tranh của chip tùy chỉnh từ Google.