Ngay từ khi ra mắt, AMD EPYC đã được định vị là dòng CPU server tiên phong hỗ trợ hệ thống AI – không chỉ tương thích với AI Accelerators mà còn phát huy tối đa sức mạnh của chúng. Trong kỷ nguyên AI-first, nơi mỗi mili-giây latency đều ảnh hưởng đến trải nghiệm và chi phí vận hành, vai trò của CPU server, đặc biệt là EPYC, ngày càng trở nên then chốt trong việc xử lý inference, training và điều phối toàn hệ thống.

CPU Server AMD EPYC – Nền tảng không thể thiếu của hệ sinh thái AI

Dù GPU thường được coi là trung tâm của hiệu năng AI, thực tế cho thấy CPU server mới là nền tảng điều phối mọi thành phần. EPYC giúp giảm độ trễ, tăng tốc độ xử lý và hỗ trợ các AI Agent thời gian thực – những ứng dụng đòi hỏi phản hồi tức thì và độ tin cậy cao. GPU không thể tự vận hành hiệu quả nếu không có CPU đủ mạnh để đảm nhiệm việc phân phối tác vụ, xử lý logic nền và quản lý dữ liệu.

Với các mô hình phức tạp như mixture-of-experts (MoE), sức mạnh của CPU ảnh hưởng trực tiếp đến throughput và hiệu quả huấn luyện mô hình. CPU cũng đảm nhận vai trò trung gian giữa các GPU node, xử lý tác vụ không tối ưu hóa cho GPU và duy trì sự ổn định hệ thống. Khi AI mở rộng quy mô, lựa chọn CPU như EPYC trở thành yếu tố quyết định khả năng vận hành và mở rộng lâu dài.

AMD EPYC 9575F – dẫn đầu về hiệu năng inference và tối ưu hệ thống

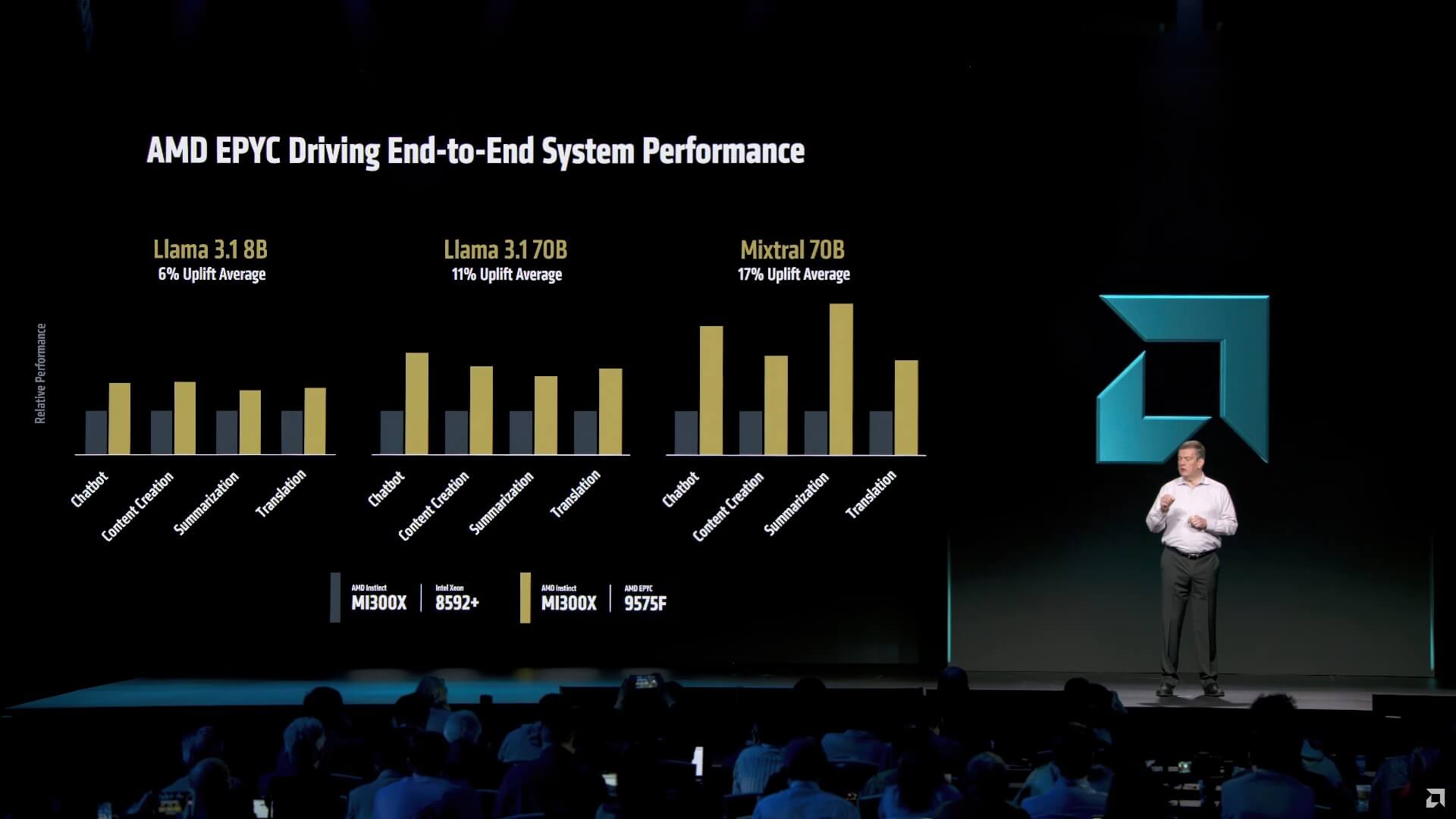

Tại sự kiện Advancing AI 2025, Benchmark thực tế cho thấy EPYC 9575F vượt trội hơn Intel Xeon 8592+ khi phối hợp với AI Accelerators Instinct MI300X. Trong các bài kiểm tra với mô hình Llama 3.1 8B, EPYC đạt hiệu năng cao hơn trung bình 6%, và có thể lên tới 17% khi xử lý các mô hình lớn hơn, đặc biệt trong môi trường yêu cầu độ trễ cực thấp – nơi EPYC 9575F đạt hiệu suất gấp hơn 10 lần đối thủ.

Điểm mạnh của EPYC đến từ kiến trúc nhiều nhân, tần số xử lý cao, cache lớn và băng thông bộ nhớ mạnh mẽ. Những yếu tố này không chỉ giúp Inference AI mượt mà mà còn hỗ trợ tốt cho Cloud Computing, Machine Learning, Big Data và Workload ảo hóa. Với khả năng mở rộng đến hàng trăm nhân xử lý, EPYC đáp ứng tốt cả hệ thống nhỏ lẫn trung tâm dữ liệu quy mô lớn, giúp tối ưu chi phí và tiết kiệm điện năng.

EPYC cũng nổi bật nhờ khả năng tích hợp liền mạch với AI Accelerators, dễ dàng mở rộng khi triển khai các kiến trúc AI phức tạp, đặc biệt là trong môi trường edge AI và doanh nghiệp – nơi yêu cầu sự linh hoạt và hiệu suất cao liên tục.

Tuy nhiên, khi so sánh hiệu năng CPU cần lưu ý yếu tố hệ sinh thái phần mềm, thế hệ sản phẩm và tối ưu hệ thống sẽ ảnh hưởng đáng kể đến kết quả benchmark. Dù vậy, thị trường AI server đang chứng kiến sự gia tăng lựa chọn EPYC nhờ hiệu suất vượt trội và chi phí cạnh tranh.

Tóm lại: AMD EPYC đang khẳng định vai trò then chốt trong kiến trúc AI hiện đại – không chỉ là CPU hiệu năng cao mà còn là hạ tầng linh hoạt giúp doanh nghiệp tối ưu chi phí, độ trễ và khả năng mở rộng. Trong bối cảnh AI trở thành chiến lược trọng tâm của mọi ngành nghề, EPYC chính là nền móng vững chắc để xây dựng hệ thống AI bền vững và hiệu quả.