Sự bùng nổ về AI đang đặt ra thách thức lớn cho các trung tâm dữ liệu, đặc biệt là bài toán làm mát khi mật độ máy chủ và nhu cầu tính toán tăng vọt. Trước đây, các hệ thống làm mát bằng không khí đã đủ dùng, nhưng với các siêu máy tính AI hiện đại, giải pháp này không còn đáp ứng được. Đó là lý do vì sao Nvidia vừa ra mắt các hệ thống Rack AI thế hệ mới, tích hợp công nghệ Liquid Cooling hiện đại, hứa hẹn thay đổi hoàn toàn cách vận hành và phát triển trung tâm dữ liệu AI trong tương lai.

Nvidia đột phá với hệ thống Rack AI mới ứng dụng Liquid Cooling

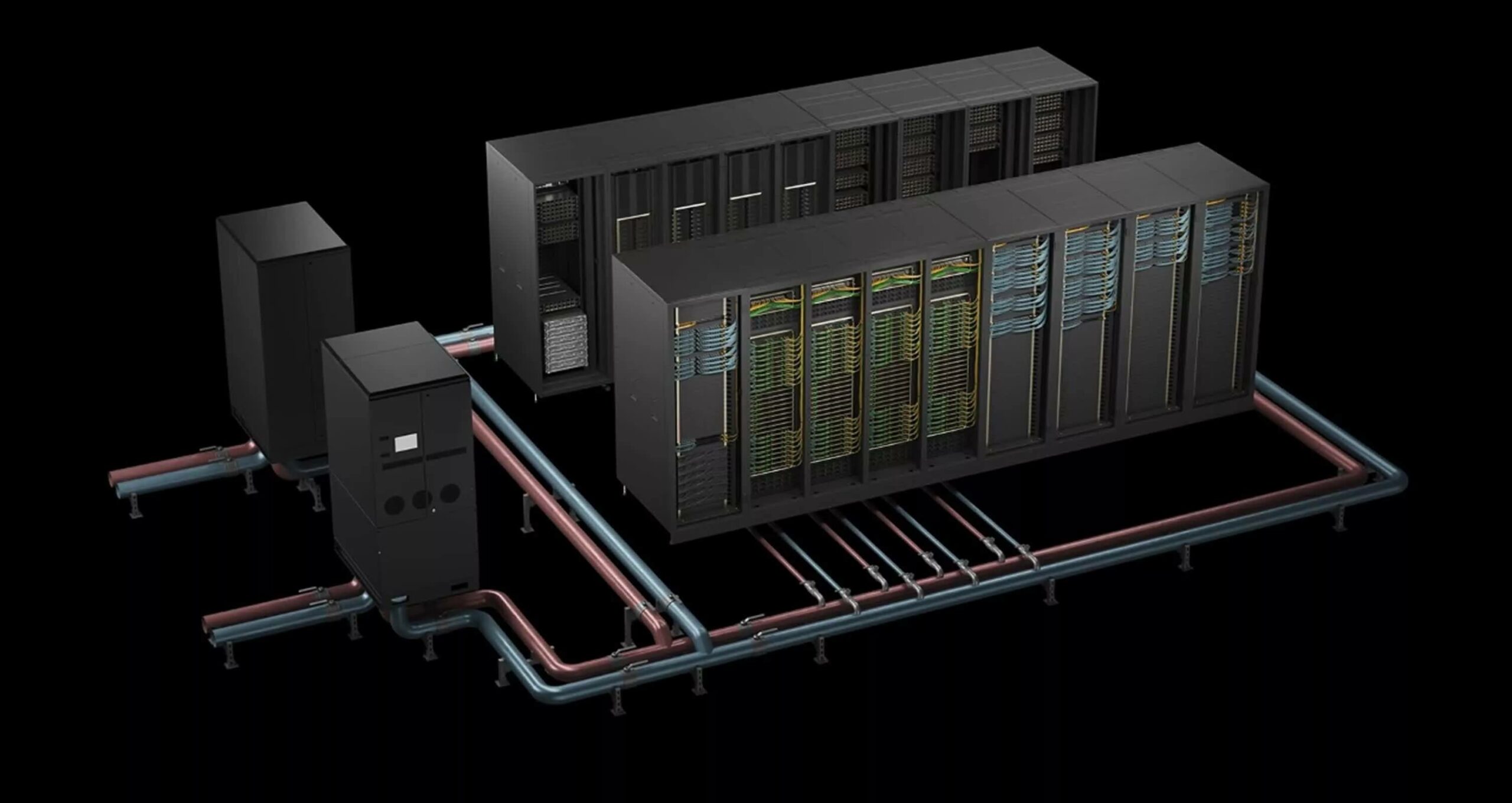

Nvidia vừa công bố các hệ thống RACK AI mới như GB200 NVL72 và GB300 NVL72, được thiết kế chuyên biệt cho các trung tâm dữ liệu AI hiệu năng cao. Đặc biệt, các hệ thống này đạt mật độ tính toán lên tới 120-140 kW mỗi rack, cao gấp hơn 7 lần so với rack truyền thống. Để xử lý lượng nhiệt cực lớn này, Nvidia đã áp dụng công nghệ Làm mát bằng chất lỏng Liquid Cooling trực tiếp đến chip – một bước tiến lớn so với làm mát bằng không khí.

Với Direct-To-Chip Liquid Cooling, chất làm mát tuần hoàn trực tiếp qua các tấm gắn lên GPU và CPU, cho hiệu suất truyền nhiệt vượt trội. Nhờ đó, hệ thống có thể vận hành ổn định, duy trì hiệu suất cao mà không lo quá nhiệt. Ngoài ra, hệ thống còn sử dụng mô hình vòng kín (Closed-Loop), chất làm mát không bị bay hơi và được tuần hoàn liên tục, gần như loại bỏ hoàn toàn hao hụt nước. Các Coolant Distribution Units (CDU) cấp rack có thể xử lý tải nhiệt lên tới 2MW, giảm mạnh phụ thuộc vào chiller cơ học, tiết kiệm điện nước đáng kể.

Một điểm ấn tượng khác là các đầu nối nhanh Quick-Disconnect Fittings giúp bảo trì, thay thế linh kiện dễ dàng mà không làm mất áp suất hay rò rỉ chất lỏng. Điều này rất quan trọng khi vận hành hệ thống lớn, liên tục cần bảo trì hoặc nâng cấp.

Ưu điểm vượt trội và thách thức của Liquid Cooling trong trung tâm dữ liệu AI

Việc đưa Liquid Cooling vào các hệ thống rack AI giúp giảm đáng kể chi phí vận hành nhờ tiết kiệm điện và nước. Theo Nvidia, hiệu quả năng lượng tăng gấp 25 lần, hiệu quả sử dụng nước gấp 300 lần so với các phương pháp làm mát truyền thống. Điều này đặc biệt phù hợp cho các trung tâm dữ liệu AI quy mô lớn, nơi nhu cầu tính toán và mật độ máy chủ ngày càng tăng, đi kèm yêu cầu bảo vệ môi trường và phát triển bền vững.

Làm mát bằng chất lỏng Liquid Cooling còn giúp tăng mật độ máy chủ, đáp ứng nhu cầu xử lý AI thế hệ mới với hàng nghìn tỷ tham số. Đồng thời, hệ thống giảm phụ thuộc vào chiller truyền thống, giảm tiếng ồn, chi phí bảo dưỡng và cả phát thải ra môi trường. Đây là bước tiến quan trọng hướng tới trung tâm dữ liệu xanh, tiết kiệm, thân thiện môi trường.

Tuy nhiên, không phải không có thách thức. Việc triển khai các hệ thống rack AI mới này đòi hỏi đầu tư lớn để cải tạo lại hạ tầng cho phù hợp với Liquid Cooling. Hệ thống kín cũng khiến bảo trì phức tạp hơn, cần các đầu nối đặc biệt và quy trình kỹ thuật nghiêm ngặt để tránh rò rỉ chất lỏng. Ngoài ra, giải pháp này chưa phù hợp với các trung tâm dữ liệu nhỏ, hoặc nơi không có khả năng nâng cấp hạ tầng.

So với Làm mát bằng không khí Air Cooling, Liquid Cooling vượt trội về hiệu quả điện năng, tiết kiệm nước, tăng mật độ rack và giảm chi phí vận hành. Tuy nhiên, đầu tư ban đầu và yêu cầu kỹ thuật cao là rào cản cần cân nhắc kỹ trước khi triển khai.

Các đối tác lớn như Schneider Electric, CoolIT, Motivair... cũng đã sẵn sàng cung cấp giải pháp đồng bộ, hỗ trợ xây dựng hệ sinh thái trung tâm dữ liệu AI hiện đại, hướng tới tầm nhìn phát triển bền vững trong tương lai.

Tóm lại: Việc Nvidia ra mắt các hệ thống rack AI mới sử dụng Làm mát bằng chất lỏng Liquid Cooling không chỉ đánh dấu bước ngoặt về công nghệ mà còn mở ra giải pháp vận hành hiệu quả, tiết kiệm và bền vững cho các trung tâm dữ liệu AI hiện đại. Dù còn nhiều thách thức về hạ tầng và kỹ thuật, nhưng đây chắc chắn là xu hướng tất yếu để đáp ứng nhu cầu AI ngày càng lớn, đồng thời góp phần bảo vệ môi trường và tối ưu chi phí vận hành cho doanh nghiệp công nghệ toàn cầu.