Samsung vừa công bố những tiến bộ vượt bậc của mình xung quanh bộ nhớ HBM4E, và theo những gì được tiết lộ, đây sẽ là một bước nhảy vọt khổng lồ về hiệu năng. Với tốc độ nhanh hơn gần 2.5 lần so với HBM3E, bộ nhớ HBM4E mới của Samsung hứa hẹn sẽ đưa khả năng tính toán của AI lên một tầm cao mới, đồng thời khơi mào cho một cuộc chiến khốc liệt về giá và hiệu năng với các đối thủ.

Chi tiết kỹ thuật của Samsung HBM4 và HBM4E

Gã khổng lồ Hàn Quốc đã có những ngày vô cùng bận rộn với mảng kinh doanh HBM (Bộ nhớ băng thông cao), đặc biệt là sau khi vừa đảm bảo được các hợp đồng mang tính quyết định với các công ty lớn như NVIDIA và AMD. Không ngủ quên trên chiến thắng, Samsung đã ngay lập tức phác thảo tương lai của mình tại Hội nghị Thượng đỉnh Toàn cầu (OCP).

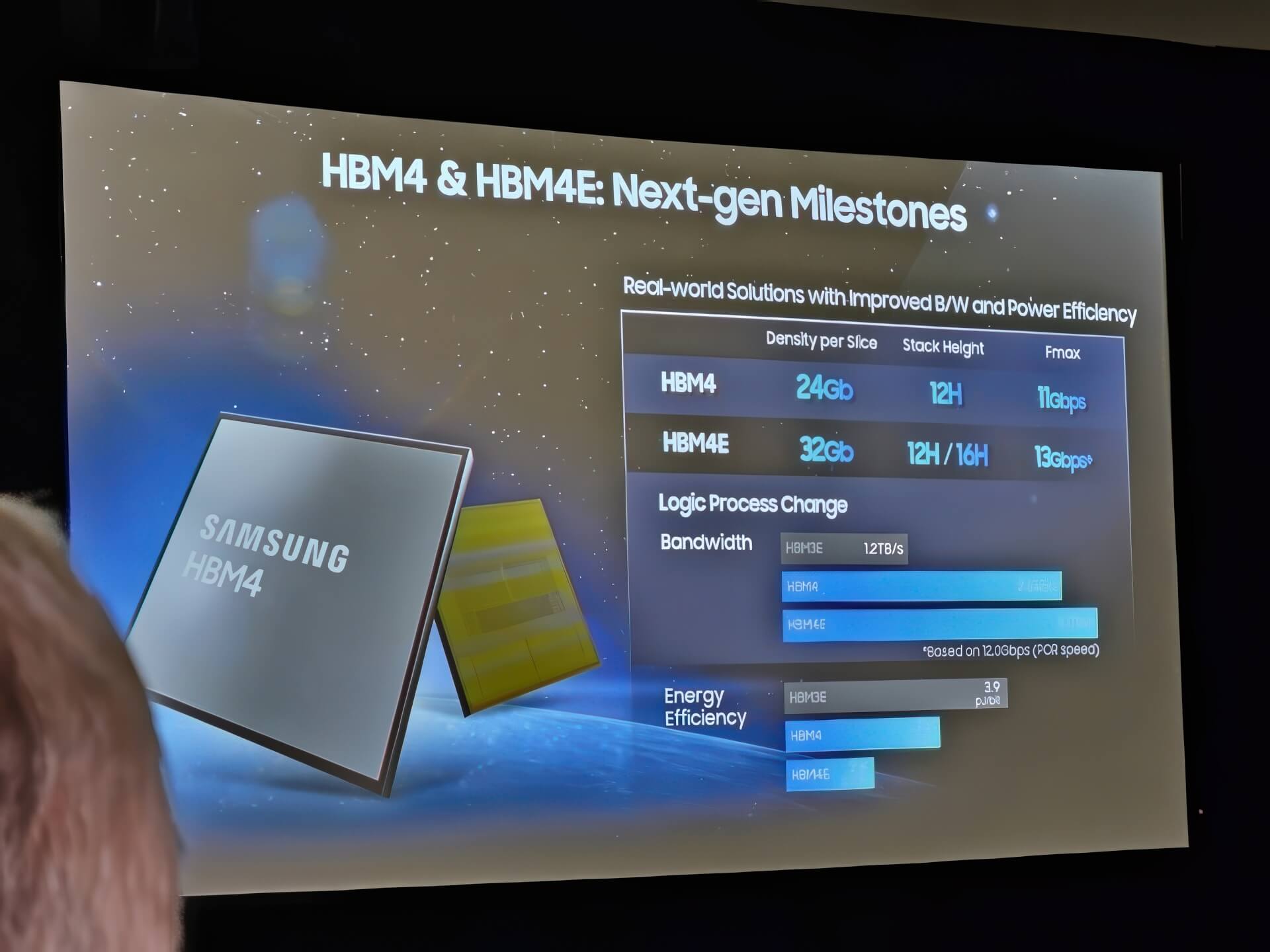

Tại sự kiện này, Samsung đã trình làng chi tiết về cả hai thế hệ bộ nhớ tương lai của mình. Đặc biệt, với quy trình HBM4E, gã khổng lồ Hàn Quốc có kế hoạch cung cấp tốc độ lên tới 13 Gbps trên mỗi stack. Con số này khi được hiện thực hóa sẽ cho phép bộ nhớ đạt băng thông đáng kinh ngạc là 3.25 TB/giây. Băng thông khổng lồ này chính là yếu tố sống còn cho các bộ xử lý AI thế hệ tiếp theo, vốn luôn “khát” dữ liệu để xử lý các mô hình ngôn ngữ lớn.

Bên cạnh HBM4E, Samsung cũng công bố một bước phát triển quan trọng xung quanh HBM4 tiêu chuẩn. Hãng tiết lộ rằng quy trình HBM4 của mình đã đạt được tốc độ pin là 11 Gbps, cao hơn đáng kể so với các tiêu chuẩn do các cơ quan có thẩm quyền như JEDEC đặt ra. Theo các báo cáo, động thái này xuất phát từ yêu cầu trực tiếp của NVIDIA, vốn đang rất cần các giải pháp HBM4 tốc độ cao để tăng cường hiệu năng cho kiến trúc “Rubin” thế hệ tiếp theo. Samsung đã trở thành nhà sản xuất đầu tiên đạt được kỳ tích này, một chiến thắng quan trọng trong cuộc đua công nghệ.

Chiến lược “lật kèo” của Samsung sau khi tụt hậu

Sự quyết liệt của Samsung có thể được hiểu là một chiến lược “lật kèo” đầy tham vọng. Theo tờ Sedaily, Samsung Electronics đã bị tụt lại phía sau các đối thủ của mình trong cuộc đua HBM3E, mất đi một phần thị phần quan trọng.

Rút kinh nghiệm từ thất bại này, Samsung đã nhắm đến băng thông cao hơn các đối thủ ngay từ giai đoạn đầu phát triển HBM4. “Cuộc chiến tốc độ” mà họ phát động dường như đang trên đà thành công. Giờ đây, chiến lược của họ là nhanh chóng chuyển tiếp sang thế hệ tiếp theo để xoay chuyển hoàn toàn tình thế, giành lại vị thế dẫn đầu. Ngoài ra, module HBM4E cũng sẽ có hiệu quả năng lượng xuất sắc, được cho là cao gần gấp đôi so với HBM3E hiện tại. Đây là một yếu tố cực kỳ quan trọng đối với các trung tâm dữ liệu AI, nơi mà chi phí điện năng là một trong những gánh nặng vận hành lớn nhất.

Vũ khí bí mật: Lò đúc bán dẫn và cuộc chiến về giá

Bên cạnh hiệu năng vượt trội, Samsung còn được cho là đang chuẩn bị một “vũ khí” khác để tấn công các đối thủ: giá cả. Các báo cáo cho biết công ty đang làm việc tích cực về cấu trúc giá cung cấp HBM4 cho NVIDIA và các khách hàng lớn khác, đưa ra một mức giá mà “khó có thể từ chối”.

Làm thế nào Samsung có thể làm được điều này? Câu trả lời nằm ở lợi thế độc nhất của họ. Một phần quan trọng của HBM4 là một con chip bán dẫn logic được sản xuất trên tiến trình 4nm. Không giống như các đối thủ, Samsung có bộ phận xưởng đúc (foundry) của riêng mình để tự chủ sản xuất thành phần đắt đỏ này và kiểm soát hoàn toàn biên lợi nhuận.

Gã khổng lồ Hàn Quốc được cho là sẽ chỉ tính biên lợi nhuận rất thấp. Mục tiêu của họ là đảm bảo rằng họ trở thành nhà cung cấp HBM lớn, giành lại thị phần đã mất. Chiến lược “phá giá” này đồng nghĩa với việc cả SK hynix và Micron sắp phải đối mặt với một cuộc cạnh tranh cực kỳ khốc liệt. Họ sẽ phải đối phó với một Samsung không chỉ mạnh về công nghệ mà còn rất “chịu chơi” về giá.

Về thời điểm chúng ta có thể thấy HBM4E ra mắt trong ngành, lộ trình được ấn định là vào đầu năm 2026. Thời điểm này sẽ diễn ra ngay bên cạnh việc sản xuất hàng loạt HBM4 tiêu chuẩn, hứa hẹn một năm bùng nổ cho thị trường bộ nhớ AI.